Red Hat OpenShift AI

Red Hat® OpenShift® AI ist eine Plattform zum Lifecycle-Management prädiktiver und generativer KI-Modelle in großem Umfang in Hybrid Cloud-Umgebungen.

Was ist Red Hat OpenShift AI?

OpenShift AI basiert auf Open Source-Technologien und bietet zuverlässige, operativ konsistente Funktionen, mit denen Teams experimentieren sowie Modelle und innovative Anwendungen bereitstellen können.

Mit OpenShift AI können Sie Daten erfassen und vorbereiten, Modelltraining und Fine Tuning durchführen, Modelle bereitstellen und überwachen sowie auf Hardwarebeschleuniger zugreifen. Durch das offene Partnernetzwerk für Hardware und Software verfügt OpenShift AI über die Flexibilität, die Sie für Ihre speziellen Use Cases benötigen.

KI-gestützte Anwendungen schneller produzieren

Hier sind die bewährten Features von Red Hat OpenShift AI und Red Hat OpenShift auf einer unternehmensgerechten KI-Anwendungsplattform vereint, die Teams zusammenbringt. Data Scientists, Engineers und Anwendungsentwicklungsteams können in einem Medium zusammenarbeiten, das Konsistenz, Sicherheit und Skalierbarkeit fördert.

Das aktuellste Release von OpenShift AI wurde entwickelt, um die Effizienz durch Zugang zu kleineren, voroptimierten Modellen zu steigern. Darüber hinaus hilft es beim Kostenmanagement für die Inferenzen mit verteilten Services durch ein vLLM-Framework. Zur weiteren Reduzierung der betrieblichen Komplexität bietet OpenShift AI fortschrittliche Tools zum Automatisieren von Deployments und Self Service-Zugriff auf Modelle, Tools und Ressourcen.

Features und Vorteile

Weniger Zeitaufwand für das KI-Infrastrukturmanagement

Geben Sie Ihren Teams einen On-Demand-Zugang zu Ressourcen, damit sie ihre Umgebungen für Training und Bereitstellung von Modellen je nach Bedarf selbst verwalten und skalieren können. Reduzieren Sie außerdem die operative Komplexität durch das Verwalten von KI-Beschleunigern (GPUs) und Workload-Ressourcen in einer skalierbaren, geclusterten Umgebung.

Getestete und unterstützte KI/ML-Tools

Red Hat verfolgt, integriert, testet und unterstützt bekannte KI/ML-Tools und die Modellbereitstellung auf der Red Hat OpenShift Anwendungsplattform, damit Sie es nicht tun müssen. OpenShift AI profitiert von mehreren Jahren Erfahrung mit dem Community-Projekt „Open Data Hub“ von Red Hat und mit Open Source-Projekten wie Kubeflow.

Flexibilität in der gesamten Hybrid Cloud

Red Hat OpenShift AI ist wahlweise als selbst gemanagte Software oder als vollständig gemanagter Cloud Service zusätzlich zu OpenShift verfügbar. Es bietet eine sichere und flexible Plattform, bei der Sie selbst entscheiden können, wo Sie Ihre Modelle entwickeln und bereitstellen möchten: On-Premise, in der Public Cloud oder sogar am Netzwerkrand.

Einsatz von Best Practices

Red Hat Consulting bietet Services, mit denen Sie Red Hat OpenShift AI in vollem Umfang installieren, konfigurieren und nutzen können.

Ganz gleich, ob Sie am Anfang Ihrer Arbeit mit KI stehen, Ihr ML-Plattformteam weiterbilden wollen oder eine Anleitung zum Aufbau Ihrer MLOps-Basis benötigen, bietet Red Hat Consulting Ihnen Support und Mentoring.

Red Hat Enterprise Linux AI

Red Hat® Enterprise Linux® AI ist eine Plattform für Basismodelle, mit der Sie Unternehmensanwendungen mithilfe von großen Sprachmodellen (LLM) der Granite-Familie nahtlos entwickeln, testen und bereitstellen können.

Partnerschaften

Holen Sie mehr aus der Red Hat OpenShift AI Plattform heraus, indem Sie sie um weitere integrierte Services und Produkte erweitern.

NVIDIA und Red Hat bieten Kunden eine skalierbare Plattform, die eine Vielzahl von KI-Use Cases mit unvergleichlicher Flexibilität beschleunigt.

Intel® und Red Hat unterstützen Organisationen dabei, die Einführung der KI zu beschleunigen und ihre KI/ML-Modelle schnell zu operationalisieren.

IBM und Red Hat bieten Open Source-Innovationen zur Beschleunigung der KI-Entwicklung, unter anderem durch IBM watsonx.aiTM, einem unternehmensgerechten KI-Studio für KI-Entwicklungsteams.

Starburst Enterprise und Red Hat unterstützen verbesserte und zeitgerechtere Erkenntnisse durch schnelle Datenanalysen auf mehreren verschiedenen und verteilten Datenplattformen.

Skalierbare Kubernetes-Infrastruktur für KI-Plattformen

Erfahren Sie, wie Sie MLOPs-Grundsätze und -Praktiken (Machine Learning) bei der Entwicklung KI-gestützter Anwendungen einsetzen können.

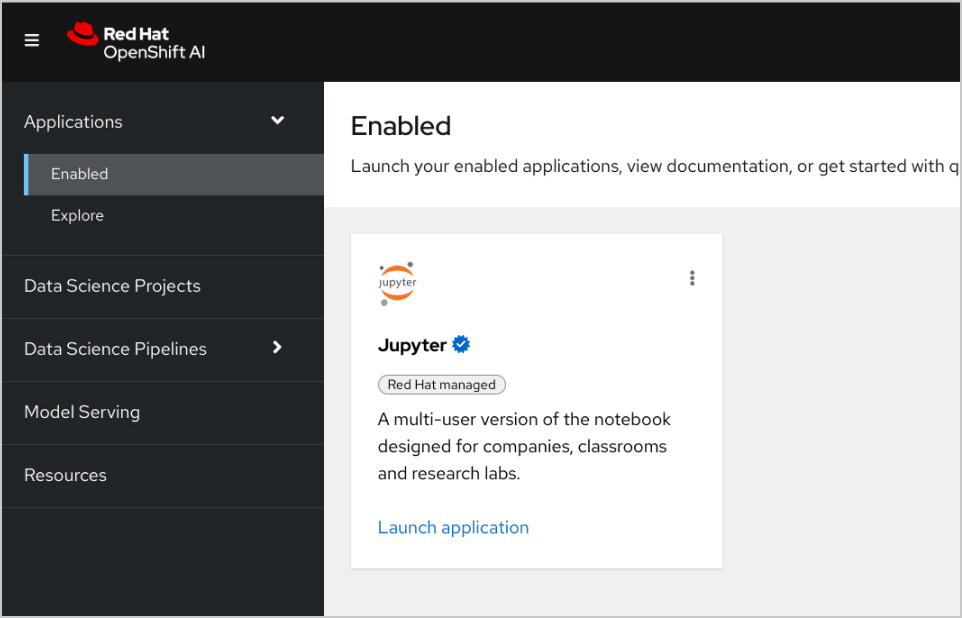

Zusammenarbeit über Model Workbenches

Stellen Sie Ihren Data Scientists vorgefertigte oder benutzerdefinierte Cluster Images zur Verfügung, damit sie mit ihrer bevorzugten IDE, wie etwa JupyterLab, an Modellen arbeiten können. Red Hat OpenShift AI verfolgt Änderungen an Jupyter, TensorFlow, PyTorch und anderen Open Source-KI-Technologien.

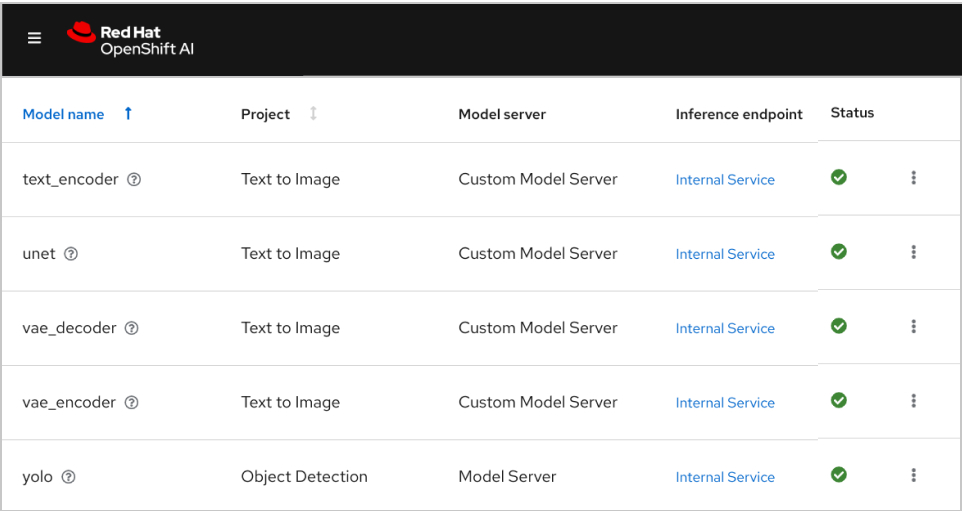

Modellbereitstellung mit Red Hat OpenShift AI skalieren

Modelle können mit einer optimierten Version von vLLM (oder anderen Modellservern Ihrer Wahl) für die Integration in KI-gestützte Anwendungen vor Ort, in der Public Cloud oder am Netzwerkrand bereitgestellt werden. Diese Modelle können basierend auf Änderungen am Quell-Notebook neu erstellt, bereitgestellt und überwacht werden.

Lösungs-Pattern

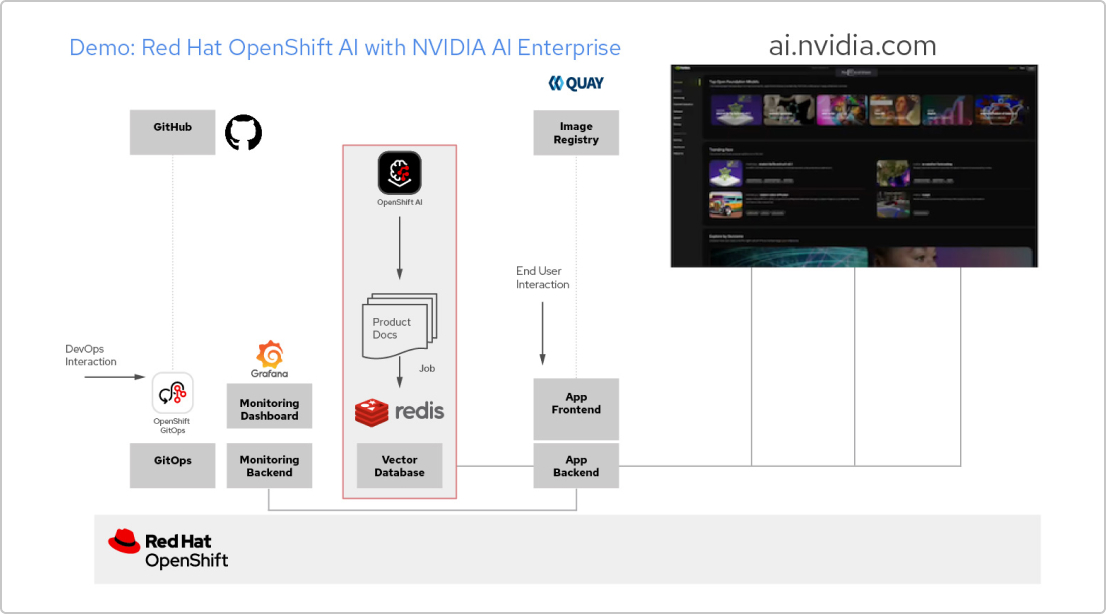

KI-Anwendungen mit Red Hat und NVIDIA AI Enterprise

Entwickeln einer RAG-Anwendung

Red Hat OpenShift AI ist eine Plattform für das Entwickeln von Data Science-Projekten und Bereitstellen von KI-gestützten Anwendungen. Sie können sämtliche für die Unterstützung von Retrieval-Augmented Generation (RAG), einer Methode zum Abrufen von KI-Antworten aus Ihren eigenen Referenzdokumenten, erforderlichen Tools integrieren. Wenn Sie OpenShift AI mit NVIDIA AI Enterprise kombinieren, können Sie mit Large Language Models (LLMs) experimentieren und so das optimale Modell für Ihre Anwendung finden.

Erstellen einer Pipeline für Dokumente

Damit Sie RAG nutzen können, müssen Sie Ihre Dokumente zunächst in eine Vektordatenbank aufnehmen. In unserer Beispielanwendung integrieren wir eine Anzahl von Produktdokumenten in eine Redis-Datenbank. Da sich diese Dokumente häufig ändern, können wir für diesen Prozess eine Pipeline erstellen, die wir regelmäßig ausführen, damit wir immer die aktuellsten Versionen der Dokumente zur Verfügung haben

Durchsuchen des LLM-Katalogs

Mit NVIDIA AI Enterprise können Sie auf einen Katalog verschiedener LLMs zugreifen. So können Sie verschiedene Möglichkeiten ausprobieren und das Modell auswählen, das die optimalen Ergebnisse erzielt. Die Modelle werden im NVIDIA API-Katalog gehostet. Sobald Sie ein API-Token eingerichtet haben, können Sie ein Modell mit der NVIDIA NIM Model Serving-Plattform direkt über OpenShift AI bereitstellen.

Auswählen des richtigen Modells

Beim Testen verschiedener LLMs können Ihre Nutzerinnen und Nutzer die einzelnen generierten Antworten bewerten. Sie können ein Grafana Monitoring Dashboard einrichten, um die Bewertungen sowie die Latenz- und Antwortzeiten der einzelnen Modelle zu vergleichen. Anhand dieser Daten können Sie dann das optimale LLM für den Produktionseinsatz auswählen.

Zugehörige Ressourcen erkunden

Case Study

DenizBank unterstützt ihre Data Scientists mit Red Hat OpenShift AI

Video

KI-Richtlinien für LLMs stellen sicher, dass Ihre generativen KI-Modelle abgesichert sind

Analystenreport

Omdia-Bericht: Aufbau einer starken operativen Basis für KI

Checkliste

5 Methoden zum erfolgreichen Einsatz von MLOps in Ihrem Unternehmen

Red Hat OpenShift AI testen

Entwicklungs-Sandbox

Für Entwicklungsteams und Data Scientists, die KI-fähige Anwendungen in einer vorkonfigurierten und flexiblen Umgebung entwickeln und damit experimentieren wollen.

60-tägige Testversion

Ihr Unternehmen will die Möglichkeiten von OpenShift AI umfassend testen? Nutzen Sie unsere 60-tägige Testversion. Sie benötigen dazu einen Red Hat OpenShift Cluster.