借助开源让 AI 为您效力

人工智能(AI)正在推动各个领域和行业的新发现和新体验。借助红帽平台,您可以更高效构建、部署、监控和使用 AI 模型及应用,并借助开源社区的速度、可信度和透明度加快进度。

用于构建和使用 AI 的特色解决方案

红帽® 企业 Linux® AI

开始使用具有开源许可的大语言模型

红帽企业 Linux AI 可以帮助您激发创造力,将生成式人工智能(生成式 AI)应用投入使用。

红帽企业 Linux AI 结合了具有开源许可的 Granite 系列 大语言模型(LLM)及 InstructLab(用于增强 LLM 功能的社区驱动型解决方案)。

红帽 OpenShift® AI

在混合云中创建和运行 AI 应用

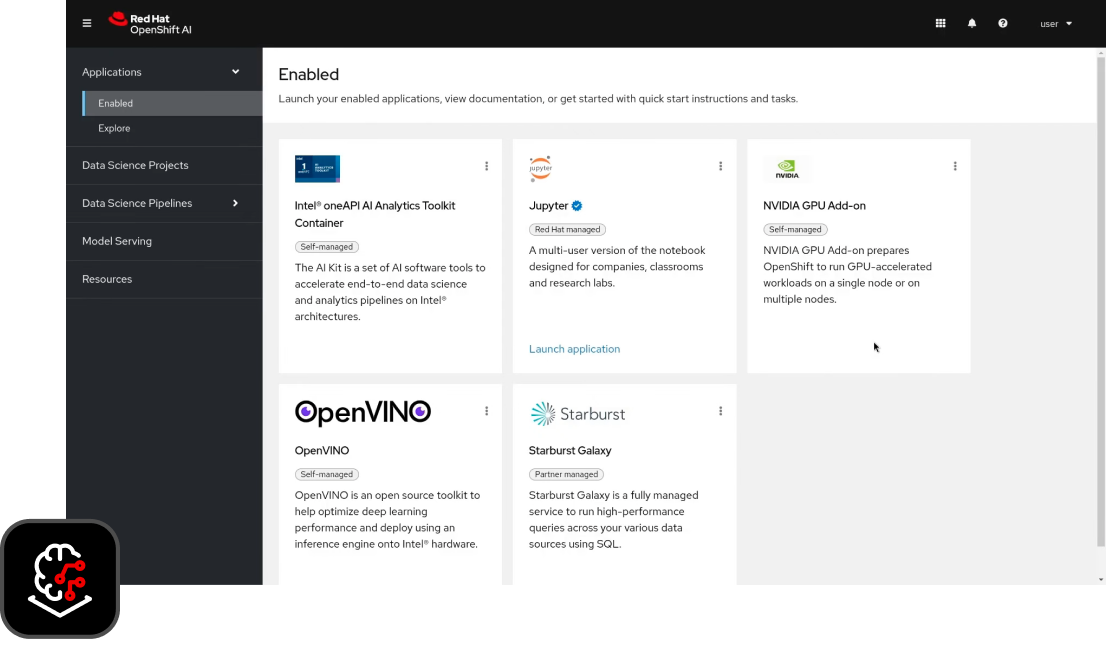

红帽 OpenShift AI 是一个开源平台,可用于为依托 AI 技术的应用构建、训练、测试和供应模型。

数据科学家和开发人员可以通过享有全方位支持的环境,在本地和公共云中 快速部署和监控 ML 工作负载和模型。

红帽 Lightspeed

通过 AI 提高效率。

继 搭载 IBM watsonx Code Assistant 的红帽 Ansible® Lightspeed 之后,红帽将推出更多生成式 AI 服务,使平台更易于使用。

红帽 Lightspeed 产品组合包括 OpenShift Lightspeed,这是一款基于生成式 AI 的虚拟助理,可用于排查问题和寻求帮助。此外,即将推出的红帽企业 Linux Lightspeed 旨在帮助厘清构建、部署和管理 Linux 过程中的问题。

为何选择红帽的 AI 产品?

凭借 Linux、容器和自动化方面的技术基础,红帽的开放混合云战略可让您根据需要随时随地灵活运行 AI 应用。

红帽企业 Linux AI 是一个基础模型平台,可无缝开发、测试和运行适用于企业级应用的 Granite 系列大语言模型(LLM)。

社区项目

红帽认为,以开源方法探索 AI 之路可消除实验和创新中的障碍。

在 OpenShift AI 沙盒中体验

借助开放数据中心及其他开源项目中的精选组件,红帽 OpenShift AI 为数据科学家和开发人员提供了一个强大的开放混合 AI/ML 平台,能够高效收集数据分析并构建依托 AI 技术的应用。您可在我们的开发人员沙盒中试用。

连接 AI 生态系统

与红帽的 AI 合作伙伴一起完善您的 AI 管道。获取解决方案,包括数据集成和准备、AI 模型开发和训练,以及基于新数据对服务和推理进行建模。

解决方案模式

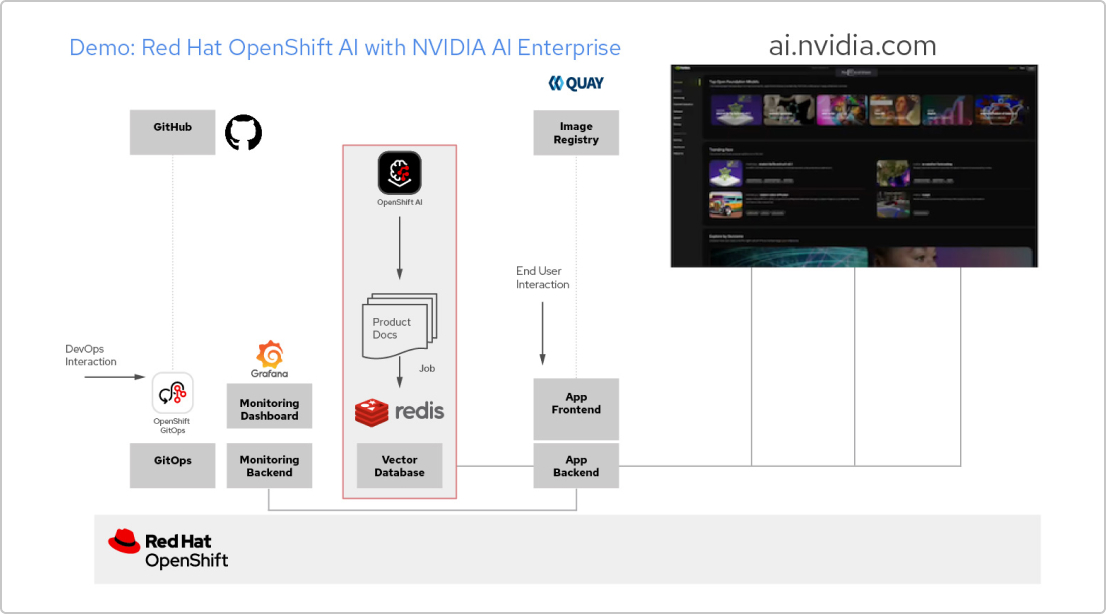

使用红帽技术和 NVIDIA AI Enterprise 构建的 AI 应用

创建 RAG 应用

红帽 OpenShift AI 是一个用于构建数据科学项目并为依托 AI 的应用提供服务的平台。您可以集成支持 检索增强生成(RAG)所需的所有工具,这是一种从自己的参考文档中获取 AI 答案的方法。将 OpenShift AI 与 NVIDIA AI Enterprise 关联后,您可以尝试各种 大语言模型(LLM),以找到适用于您应用的最佳模型。

构建文档处理管道

要使用 RAG,首先需要将文档导入到一个向量数据库中。在示例应用中,我们将一组产品文档嵌入到 Redis 数据库中。由于这些文档经常更改,我们可以为此过程创建一个管道并定期运行,以确保始终拥有最新版本的文档。

浏览 LLM 目录

NVIDIA AI Enterprise 支持访问不同 LLM 的目录,因此您可以尝试不同的选择,并选取能够提供最佳效果的模型。这些模型托管在 NVIDIA API 目录中。设置 API 令牌后,您就可以直接从 OpenShift AI 使用 NVIDIA NIM 模型服务平台来部署模型。

选择合适的模型

在测试不同的 LLM 时,您可以让用户对每个生成的响应进行评分。您还可以设置一个 Grafana 监控面板,用于比较各个模型的评分、延迟和响应时间。然后,您就可以根据这些数据来选择最适合在生产环境中使用的 LLM。

真实的 AI 技术成功案例

红帽帮助 Ortec Finance 加快增长并缩短投向市场的时间

Ortec Finance 是一家从事风险和投资管理的全球技术和解决方案提供商,该公司在使用微软 Azure 红帽 OpenShift 供应机器学习模型且采用了红帽 Openshift AI。

加利西亚银行加速客户入驻

使用基于人工智能的自然语言处理(NLP)解决方案红帽 OpenShift,该银行将验证时间从几天缩短到几分钟,准确率高达 90%。

波士顿大学搭建教育平台

波士顿大学利用红帽 OpenShift AI 扩展了一个可容纳数百名计算机科学和计算机工程用户的教学环境。