Plataformas de inteligencia artificial: ¿qué son?

Las plataformas de inteligencia artificial son conjuntos integrados de tecnologías para desarrollar, entrenar y ejecutar modelos de machine learning (aprendizaje automático). Incluyen funciones de automatización, operaciones de machine learning (MLOps), análisis de datos predictivos y mucho más. Es similar a una mesa de trabajo, con todas las herramientas de las que dispones y una base estable para diseñar y perfeccionar los modelos.

Cada vez hay más opciones a la hora de elegir una plataforma de inteligencia artificial y comenzar a utilizarla. A continuación, te presentamos los principales aspectos que debes tener en cuenta.

Tipos de plataformas de inteligencia artificial

La primera decisión que debe tomar una empresa es si comprar una plataforma de inteligencia artificial configurada previamente o diseñar una personalizada de manera interna.

Comprar una plataforma de inteligencia artificial

Si te interesa implementar rápidamente algoritmos, modelos y aplicaciones de inteligencia artificial, la mejor opción es comprar una plataforma integral y configurada previamente. Estas plataformas incluyen herramientas, repositorios de lenguajes y API que se prueban con antelación para garantizar la seguridad y el rendimiento. Algunos proveedores ofrecen modelos de inteligencia artificial básica y generativa entrenados previamente. Gracias a los recursos de integración y soporte, puedes utilizarlos en tus entornos y flujos de trabajo actuales sin inconvenientes.

Ahora, los proveedores de nube más conocidos amplían sus carteras de productos con plataformas de inteligencia artificial, como Amazon SageMaker de Amazon Web Services (AWS), Google Cloud AI Platform, Microsoft Azure AI Platform y el estudio de inteligencia artificial IBM watsonx.ai™. En muchos casos, los proveedores de las plataformas también ofrecen herramientas independientes que se pueden usar junto con otras soluciones de este tipo de tecnología e integrar a ellas.

Diseñar una plataforma de inteligencia artificial

Para satisfacer ciertos casos prácticos particulares o requisitos de privacidad avanzados, algunas empresas deben personalizar y gestionar completamente su propia plataforma de inteligencia artificial. Por ejemplo, Uber desarrolló una plataforma que utiliza las tecnologías de procesamiento del lenguaje natural (NLP) y visión artificial para mejorar sus funciones de GPS y detección de choques. Otro caso es el de Syapse, una empresa de atención médica basada en datos, que creó Syapse Raydar®, una plataforma que utiliza la inteligencia artificial para traducir los datos oncológicos en información práctica.

Al diseñar una plataforma de inteligencia artificial, puedes obtener el control total del entorno y repetir los procesos en función de las necesidades específicas de tu empresa. Sin embargo, para poner en funcionamiento una plataforma, se requiere más trabajo inicial, y no pueden tercerizarse el mantenimiento, el soporte ni la gestión.

Soluciones open source para la inteligencia artificial

Las comunidades open source impulsan los avances en inteligencia artificial y machine learning. Si optas por una solución de software open source como base para tus iniciativas de inteligencia artificial, contarás con una comunidad de compañeros y especialistas que trabajan permanentemente para mejorar los marcos y las herramientas que más utilizas. Muchas empresas comienzan con herramientas open source y a partir de ahí expanden su infraestructura. TensorFlow y PyTorch son plataformas open source que ofrecen bibliotecas y marcos para desarrollar aplicaciones de inteligencia artificial.

Recursos de Red Hat

Funciones necesarias en las plataformas de inteligencia artificial

MLOps

Las operaciones de machine learning (MLOps) son un conjunto de prácticas para los flujos de trabajo cuyo objetivo es optimizar el proceso de implementación y mantenimiento de los modelos de machine learning. La plataforma de inteligencia artificial que elijas debe respaldar las fases de MLOps, como el entrenamiento, la distribución y la supervisión de los modelos.

Las operaciones de modelos de lenguaje de gran tamaño (LLMOps) son un subconjunto de MLOps que se centra en las prácticas, técnicas y herramientas que se usan para la gestión operativa de estos modelos en los entornos de producción. Los modelos de lenguaje de gran tamaño (LLM) pueden realizar tareas como generar texto, resumir contenido y clasificar información, pero consumen una gran cantidad de recursos informáticos de las unidades de procesamiento gráfico (GPU), de manera que la plataforma de inteligencia artificial debe tener la solidez necesaria para admitir y respaldar la entrada de datos y los resultados de los LLM.

Inteligencia artificial generativa

La inteligencia artificial generativa es un tipo de tecnología que crea contenido nuevo a partir de redes neuronales y de modelos de deep learning (aprendizaje profundo), que están entrenados con conjuntos grandes de datos. Con el entrenamiento adecuado, los modelos podrán aplicar el aprendizaje en casos reales, lo cual se conoce como inferencia de la inteligencia artificial.

Abarca muchas de las funciones que los usuarios finales asocian a la inteligencia artificial, como la generación de texto e imágenes, el aumento de datos y la inteligencia artificial conversacional, como los chatbots. Es importante que tu plataforma permita que las funciones de inteligencia artificial generativa se ejecuten con agilidad y precisión.

Flexibilidad

Los modelos solo tienen éxito si pueden ajustarse, para lo cual los equipos de análisis de datos necesitan una solución que les permita diseñar e implementar los modelos de inteligencia artificial, experimentar con ellos y perfeccionarlos, así como trabajar con otros equipos, todo desde un solo lugar. Para ello, se requiere una gran cantidad de datos y capacidad informática, pero principalmente una plataforma que pueda ocuparse de todo.

Una vez que tus modelos funcionen bien, querrás reproducirlos en diferentes entornos, ya sea en las instalaciones, en plataformas de nube pública o en el extremo de la red. Esto será posible con una solución flexible y con capacidad de ajuste.

Automatización

Cuando tu empresa pase de tener unos pocos modelos para implementar en la fase de producción a tener una gran cantidad de ellos, deberás considerar la automatización. Al automatizar los canales de análisis de datos, podrás convertir los procesos más exitosos en operaciones repetibles, lo cual no solo agiliza los flujos de trabajo, sino que también mejora la experiencia de los usuarios y la capacidad de ajuste. Además, elimina las tareas repetitivas y permite que los analistas de datos y los ingenieros dediquen su tiempo a generar innovaciones, repetir procesos y perfeccionarlos.

Herramientas e integraciones

Los desarrolladores y los analistas de datos dependen de herramientas e integraciones para diseñar aplicaciones y modelos e implementarlos de manera eficiente. La plataforma de inteligencia artificial que elijas debe admitir las herramientas, los lenguajes y los repositorios que ya usan tus equipos e integrarse a toda tu stack tecnológica y a las soluciones de los partners.

Seguridad y normativas

Establece prácticas de seguridad sólidas en tu plataforma de inteligencia artificial para reducir los riesgos de seguridad y proteger tus datos. Durante las operaciones diarias de desarrollo y entrenamiento de los modelos, es fundamental analizar los sistemas en busca de puntos vulnerables y exposiciones comunes (CVE) y proteger las aplicaciones y los datos de manera operativa mediante la gestión del acceso, la segmentación de las redes y el cifrado.

Responsabilidad y control

Tu plataforma de inteligencia artificial también debe permitirte usar y supervisar los datos con la tranquilidad de que se respetarán las normas éticas y se evitarán los incumplimientos normativos. Para proteger los datos tanto de la empresa como de los usuarios, es importante que elijas una plataforma que respalde las estrategias de supervisión, seguimiento y gestión de los riesgos durante todo el ciclo de vida del machine learning. Además, la plataforma debe seguir los estándares de cumplimiento y seguridad de los datos de la empresa.

Soporte

Una de las principales ventajas de contar con una plataforma de inteligencia artificial integral y configurada previamente es el soporte incluido. Gracias al seguimiento y la corrección permanentes de los errores en todas las implementaciones, tus modelos funcionan mejor. Algunos proveedores de plataformas de inteligencia artificial ofrecen recursos de capacitación e integración destinados a ayudar a tus equipos a ponerlas en funcionamiento rápidamente. Las empresas que elijan diseñar su propia plataforma con herramientas open source pueden optar por proveedores que brinden soporte para la infraestructura y los conjuntos de funciones de machine learning.

Casos prácticos de las plataformas de inteligencia artificial

Telecomunicaciones

Con los servicios integrales de inteligencia artificial, puedes optimizar distintos aspectos del sector de las telecomunicaciones, como el rendimiento de las redes y la calidad de los productos y los servicios que ofreces. Esto incluye mejoras audiovisuales y de calidad del servicio, así como iniciativas de prevención de la pérdida de clientes.

Salud

Una plataforma de inteligencia artificial sólida puede traer ventajas transformadoras en el sector de salud, como diagnósticos más rápidos, avances en las investigaciones clínicas y mayor acceso a los servicios. Todo esto mejora los resultados de los pacientes, ya que permite que los médicos y demás especialistas ofrezcan diagnósticos y planes de tratamiento más precisos.

Fabricación

La automatización inteligente que se basa en el machine learning transforma toda la cadena de suministro del proceso de fabricación. Gracias al análisis predictivo y la robótica industrial, se reduce la carga que implican las tareas repetitivas y se implementan flujos de trabajo más efectivos de forma inmediata.

Red Hat puede ayudarte a diseñar tu solución de inteligencia artificial

El diseño de soluciones de inteligencia artificial flexibles y confiables es nuestra prioridad en relación con las plataformas de inteligencia artificial.

Red Hat® AI es nuestra cartera de productos de inteligencia artificial basada en soluciones que nuestros clientes ya conocen.

Red Hat AI permite que las empresas:

- adopten la inteligencia artificial y generen innovaciones con ella con rapidez;

- superen las complejidades de la distribución de las soluciones de inteligencia artificial;

- realicen implementaciones en cualquier entorno.

Ajusta la infraestructura con flexibilidad

Una vez que estés listo para ajustar la infraestructura, nuestra plataforma Red Hat AI brindará a los desarrolladores las herramientas para diseñar, implementar y gestionar las aplicaciones que utilizan la inteligencia artificial.

Gracias a la colaboración permanente y respaldada, puedes personalizar las aplicaciones de los modelos de inteligencia artificial de los casos prácticos empresariales de forma rápida y sencilla.

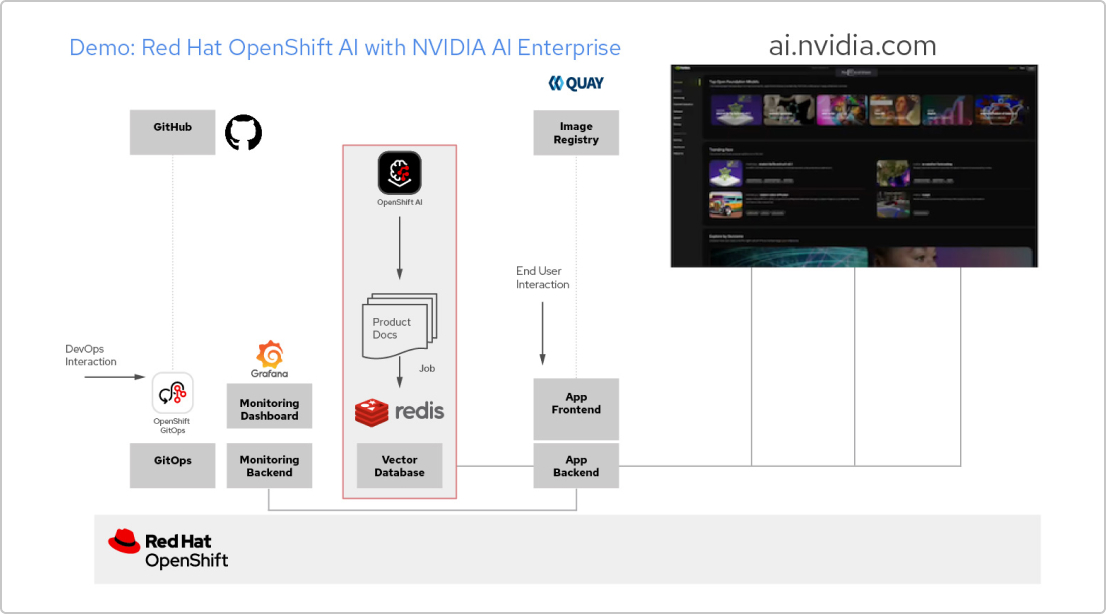

Patrón de soluciones: aplicaciones de inteligencia artificial con Red Hat y NVIDIA AI Enterprise

Crea una aplicación de RAG

Red Hat OpenShift AI es una plataforma que permite diseñar proyectos de análisis de datos y distribuir aplicaciones que utilizan la inteligencia artificial. Puedes integrar todas las herramientas que necesitas para admitir la generación aumentada por recuperación (RAG), un método que permite obtener respuestas de inteligencia artificial a partir de tus propios documentos de referencia. Al conectar OpenShift AI con NVIDIA AI Enterprise, puedes realizar pruebas con modelos de lenguaje de gran tamaño (LLM) para encontrar el modelo óptimo para tu aplicación.

Crea un canal para la documentación

Para utilizar la RAG, primero necesitas ingresar tus documentos a una base de datos vectorial. En nuestra aplicación de ejemplo, incorporamos un conjunto de documentos de productos a una base de datos Redis. Como estos documentos cambian con frecuencia, podemos crear una canal para este proceso que ejecutaremos periódicamente, de modo que siempre dispongamos de las últimas versiones de los documentos.

Explora el catálogo de LLM

NVIDIA AI Enterprise brinda acceso a un catálogo de diferentes modelos de lenguaje de gran tamaño para que puedas probar distintas opciones y seleccionar el modelo que ofrezca los mejores resultados. Los modelos se alojan en el catálogo de API de NVIDIA. Una vez que hayas configurado un token de API, podrás implementar un modelo utilizando la plataforma de distribución de modelos NVIDIA NIM directamente desde OpenShift AI.

Elige el modelo adecuado

A medida que pruebas diferentes modelos de lenguaje de gran tamaño, los usuarios pueden valorar cada respuesta generada. Configura un panel de supervisión de Grafana para comparar las calificaciones, así como la latencia y el tiempo de respuesta de cada modelo. Luego, aprovecha esos datos a la hora de elegir el mejor modelo para la fase de producción.

¿Cuál es el nivel de soberanía de tu estrategia? Presentamos la herramienta Red Hat Sovereignty Readiness Assessment

La herramienta Red Hat Sovereignty Readiness Assessment es una evaluación de autoservicio basada en la web que proporciona una referencia clara y objetiva del control digital de tu organización en siete áreas fundamentales.