Resumen

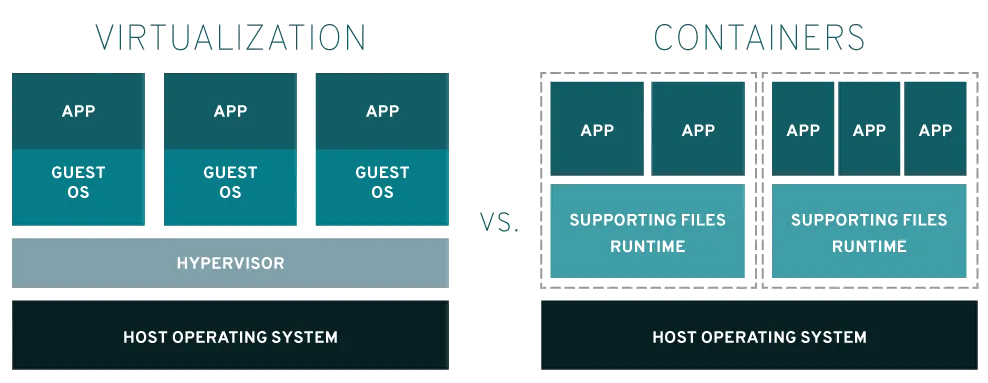

Los contenedores y las máquinas virtuales (VM) son dos enfoques para empaquetar entornos informáticos que combinan varios elementos de TI y los aíslan del resto del sistema. La diferencia principal entre ambos son los elementos que se aíslan, lo que a su vez afecta la adaptabilidad y la portabilidad de cada enfoque.

¿Qué es un contenedor?

Un contenedor es una unidad de software que reúne todos los elementos y las funciones que se necesitan para ejecutar una aplicación. Las aplicaciones más modernas están compuestas de varios contenedores, cada uno de los cuales cumple una función específica. Por lo general, los contenedores se miden en megabytes y no utilizan hipervisor. Se suelen considerar una manera más rápida y ágil de gestionar el aislamiento de los procesos.

Uno de los factores importantes que contribuyen al éxito de los contenedores es su portabilidad.Así como se pueden interconectar los bloques LEGO™, los contenedores individuales se pueden intercambiar y mover fácilmente entre distintos entornos. Una vez que una aplicación y sus dependencias se empaquetan en un contenedor, este se puede implementar en cualquier lugar que se necesite (la computadora portátil del desarrollador, el centro de datos, la nube o el extremo de la red) sabiendo que funcionará de la misma manera.

La plataforma open source Docker, que sirve para diseñar, implementar y gestionar aplicaciones organizadas en contenedores, ha tenido un papel fundamental en la evolución de la tecnología de contenedores a lo largo de los años.

Recursos de Red Hat

¿Qué es una máquina virtual?

Las máquinas virtuales desempeñan un papel crucial en el cloud computing, ya que imitan a las computadoras físicas ejecutando sistemas operativos en instancias aisladas. Por lo general, varias máquinas virtuales se alojan en un solo servidor, con un hipervisor que funciona como una capa de software ligera entre el host físico y las máquinas virtuales. Este hipervisor gestiona el acceso a los recursos de manera eficiente, lo cual permite que las máquinas virtuales funcionen como servidores distintos y, al mismo tiempo, ofrece mayor flexibilidad y agilidad.

La popularidad de las máquinas virtuales comenzó en la primera década del siglo XXI debido a las iniciativas de consolidación y ahorro de costos, pero su uso evolucionó a lo largo del tiempo. Las empresas han ampliado las implementaciones de máquinas virtuales para abarcar diversos casos prácticos, entre los que se incluyen la provisión de recursos para las aplicaciones según sea necesario y la optimización del acceso a recursos costosos, como las GPU.

También fueron la base de muchos de los primeros entornos de cloud computing, ya que facilitaron la virtualización de los recursos y permitieron la arquitectura multiempresa y el aislamiento, es decir, que varios clientes ejecutaran sistemas con los mismos recursos.

Las máquinas virtuales tienen su propio sistema operativo, lo cual les permite realizar varias funciones que utilizan muchos recursos al mismo tiempo. Como cuentan con una mayor cantidad de recursos disponibles, pueden extraer, dividir, duplicar y simular sistemas operativos, equipos de escritorio, bases de datos, conexiones de red y servidores completos.

TI en la nube y TI tradicional

Más allá de las diferencias tecnológicas, la comparación entre los contenedores y las máquinas virtuales es una comparación indirecta entre las prácticas modernas de la TI en la nube y las arquitecturas de TI tradicionales.

Las prácticas modernas de la TI

(el desarrollo en la nube, la CI/CD y DevOps) son posibles porque las cargas de trabajo se dividen en las unidades de servicio más pequeñas posibles, normalmente una función o un microservicio, y se ejecutan en aislamiento, donde se desarrollan, implementan, gestionan y adaptan de manera independiente.

La mejor manera de empaquetar estas unidades es en contenedores, ya que permiten que varios equipos trabajen en partes individuales de una aplicación o un servicio sin interrumpir o poner en peligro el código empaquetado en otros contenedores.

Las arquitecturas de TI tradicionales

(monolíticas y heredadas) mantienen conectados directamente todos los elementos de una carga de trabajo, los cuales no pueden funcionar sin una arquitectura mayor. Dado que no es posible dividir estos elementos, deben empaquetarse como una unidad completa dentro de un entorno más grande, por lo general una máquina virtual.

Antes era común diseñar y ejecutar una aplicación completa dentro de una máquina virtual. Sin embargo, el hecho de que todo el código y las dependencias se almacenaran en un solo lugar dio como resultado máquinas virtuales de gran tamaño que sufrían fallas en cascada y tiempo de inactividad al implementar las actualizaciones.

¿Cómo funcionan?

Virtualización

El software llamado hipervisor separa los recursos de las máquinas físicas para que puedan dividirse y destinarse a las máquinas virtuales. Cuando un usuario emite una instrucción de una máquina virtual que requiere recursos adicionales del entorno físico, el hipervisor transmite la solicitud al sistema físico y almacena los cambios en la memoria caché. Las máquinas virtuales parecen servidores físicos y actúan como tales, lo que puede multiplicar las desventajas de las dependencias de las aplicaciones y los grandes espacios del sistema operativo, que ni siquiera se necesitan para ejecutar una sola aplicación o microservicio en la mayoría de los casos.

Contenedores

Todos los elementos de un contenedor se empaquetan y envían mediante una imagen, es decir, un archivo que incluye todas las bibliotecas y las dependencias. Estos archivos son similares a los paquetes de instalación de software (por ejemplo, los RPM en Linux), pero solo necesitan un kernel y un tiempo de ejecución del contenedor compatibles para que la aplicación se ejecute, independientemente del sistema operativo que se haya utilizado para crear el contenedor o del origen de las bibliotecas que contenga. Como los contenedores son tan pequeños, suele haber cientos de ellos con un nivel de acoplamiento bajo. Por ello, se utilizan plataformas de organización de contenedores (como Red Hat OpenShift y Kubernetes) para configurarlos y gestionarlos.

¿Cuál deberías utilizar?

Eso depende de si necesitas una instancia pequeña de algo que se pueda trasladar con facilidad (contenedores) o una asignación semipermanente de recursos personalizados de TI.

Además, hay que tener en cuenta otros factores, como la arquitectura de la aplicación, las prácticas de desarrollo, la seguridad y los requisitos normativos.

Debido a que los contenedores son pequeños y ligeros, pueden implementarse con facilidad en los equipos con sistemas de servidor dedicado (bare metal), así como en los entornos de nube pública, privada, híbrida y multicloud. Asimismo, es muy frecuente que se ejecuten en máquinas virtuales, ya que las empresas cuentan con una infraestructura desarrollada en torno a ellas. Todo esto demuestra la flexibilidad que ofrecen los contenedores.

También son el entorno ideal para implementar las aplicaciones actuales desarrolladas originalmente en la nube. Estas consisten en conjuntos de microservicios diseñados para proporcionar un desarrollo uniforme y una experiencia de gestiónautomatizada en los entornos de nube pública, privada, híbrida y multicloud. Las aplicaciones desarrolladas en la nube agilizan el diseño de aplicaciones nuevas, la optimización de las actuales y la conexión entre todas ellas.

Si comparamos las máquinas virtuales con los contenedores, estos últimos son mejores para las siguientes funciones:

- diseñar aplicaciones en la nube;

- empaquetar microservicios;

- incorporar aplicaciones a las prácticas de DevOps o CI/CD;

- trasladar proyectos de TI adaptables en un entorno de TI diverso.

Si comparamos las máquinas virtuales con los contenedores, aquellas son mejores para las siguientes funciones:

- alojar cargas de trabajo tradicionales, monolíticas y heredadas;

- aislar ciclos de desarrollo riesgosos;

- proporcionar recursos infraestructurales (como redes, servidores y datos);

- ejecutar un sistema operativo diferente dentro de otro (por ejemplo, ejecutar Unix en Linux).

Si tienes aplicaciones que se ejecutan en máquinas virtuales y en contenedores, Red Hat Service Interconnect te puede ayudar a conectar las aplicaciones y los servicios en distintos entornos.

Diferencias entre los servidores dedicados (bare metal), las máquinas virtuales y los contenedores

Las máquinas virtuales y los contenedores se pueden implementar en diversos tipos de infraestructura, incluidos los servidores dedicados (bare metal).

¿Qué es un servidor dedicado (bare metal)?

Este término hace referencia a una computadora o un servidor que se ejecuta en un hardware físico y cuyo funcionamiento no requiere el uso de hipervisores, máquinas virtuales ni contenedores. Se los conoce como servidores dedicados porque los elementos de hardware no se comparten con otros usuarios y, por lo tanto, se encuentran totalmente dedicados a un único tenant.

Son muy rápidos y potentes, por lo que pueden procesar grandes volúmenes de datos con baja latencia. Con ellos, el usuario tiene pleno control sobre la infraestructura de su servidor, lo cual implica que puede elegir su propio sistema operativo y adaptar el hardware y el software a las necesidades específicas de sus cargas de trabajo.

Sin embargo, si bien este tipo de implementaciones resultan muy útiles en aquellos casos en los que el rendimiento y el acceso directo al hardware son fundamentales, es posible que no ofrezcan el mismo nivel de flexibilidad y gestión de los recursos que los contenedores o las máquinas virtuales.

¿Puedo alojar máquinas virtuales en servidores dedicados (bare metal)?

Sí. Los servidores dedicados (bare metal) pueden alojar máquinas virtuales si se les agrega un hipervisor y un software de virtualización.

¿Puedo alojar contenedores en servidores dedicados (bare metal)?

Sí. Algunas plataformas, como Docker, Kubernetes y Podman, están diseñadas para que los usuarios puedan gestionar e implementar los contenedores según sea necesario en diversas infraestructuras, incluidos los servidores dedicados (bare metal).

Motivos para elegir Red Hat

Red Hat® OpenShift® es una sola plataforma de aplicaciones empresarial basada en contenedores con opciones de implementación y uso que admite todas las aplicaciones y los entornos. Las empresas pueden utilizarla para diseñar, implementar, ejecutar y gestionar aplicaciones donde sea, de manera rápida y segura y según sea necesario.

Red Hat OpenShift Virtualization, una función de Red Hat OpenShift, permite que los equipos de TI ejecuten las máquinas virtuales junto con los contenedores en la misma plataforma de Kubernetes, lo cual facilita la gestión y mejora el tiempo de producción.

Red Hat OpenShift Virtualization se basa en los proyectos open source KVM y KubeVirt, y forma parte de la solución integral de virtualización de Red Hat. Migra tus máquinas virtuales ahora con el kit de herramientas de migración para virtualización, que brinda las herramientas que necesitas para comenzar el proceso de migración en unos pocos pasos sencillos.Con Red Hat Ansible® Automation Platform, automatiza las tareas para agilizar cada etapa de la distribución, desde la migración según las necesidades hasta las operaciones del día 2 y la resolución de problemas. Supervisa la seguridad y el rendimiento de tus máquinas virtuales desde una sola consola con Red Hat Advanced Cluster Management for Kubernetes. Con las opciones de soporte adicional y las integraciones de los partners para el almacenamiento, la generación de backups, la recuperación ante desastres y la gestión de las redes, puedes confiar en que Red Hat mantendrá el buen funcionamiento de tu infraestructura virtual en toda la nube híbrida y te ayudará a modernizar los sistemas a tu propio ritmo.

El blog oficial de Red Hat

Obtenga la información más reciente sobre nuestro ecosistema de clientes, socios y comunidades.